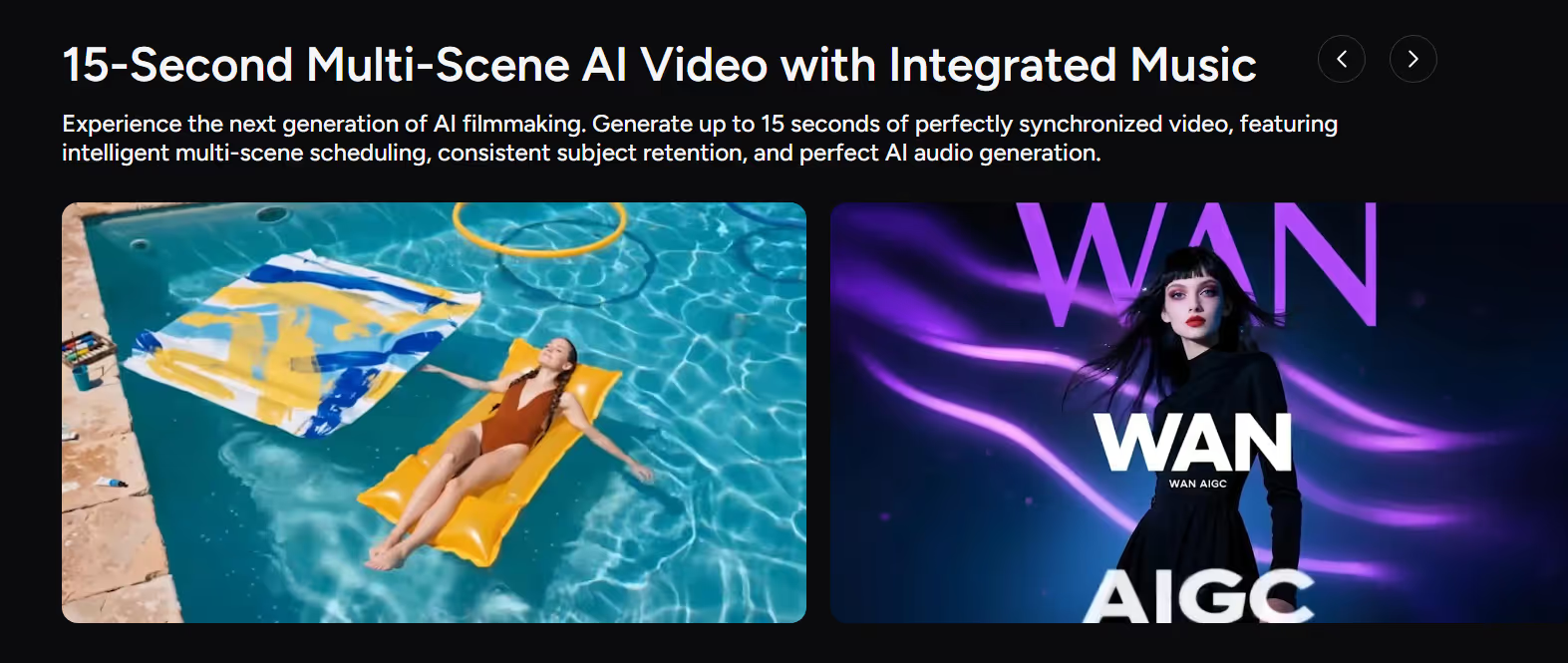

WAN 2.6 の紹介

アリババ WAN シリーズはすぐに主要なファミリーの1つになりました AI ビデオモデル、シネマティックビジュアル、強力なモーションコントロール、マルチモーダル生成で知られています。と ワン 2.6、このモデルは大きな一歩を踏み出しました。 15 秒のマルチシーンビデオ、ネイティブオーディオ、よりスマートなナラティブコントロールにより、プロ仕様の短編動画やコマーシャルコンテンツを直接制作できます。

WAN 2.6はアリババクラウドモデルスタジオで両方として利用できます テキストからビデオ (2.6t-t2v まで) そして イメージ・トゥ・ビデオ (2.6‑i2V の場合)、720pおよび1080pレンダリングをサポート 自動ボイスオーバー とカスタムオーディオインポート。

オン アコール、WAN 2.6は機能として完全に統合されました AI ビデオジェネレーター、クリエイターにシンプルな生成インターフェースを提供する 音楽、一貫性のある被写体、映画のような動きが収録された15秒のマルチシーンAIビデオ プロンプト、画像、音声から。

WAN 2.6 の主な機能とメジャーアップグレード

1. 15 秒のマルチシーンシネマティックビデオ

で最も目に見えるアップグレード WAN 2.6 人工知能ビデオ そのサポートは 15 秒まで 高品質ビデオを一世代で。

主なメリット:

- マルチシーンのナラティブコントロール — 自動的にショット間のプランニングと切り替えができるため、1つのクリップ内でシンプルなストーリーアークを作成できます。

- シーン全体で一貫した被写体 —シーンが変わってもキャラクターやオブジェクトを同じアイデンティティとして維持できるため、ストーリーテリングや製品ビデオに最適です。

- 720p/1080pのシネマティックな画質 — 短編コンテンツ、広告、予告編でプロが使用できるように設計されています。

クリエイターにとって、WAN 2.6はもはや「クールなショートクリップ」エンジンではなく、1つのパスでミニストーリーのビートを配信できるということです。

2。ネイティブオーディオ、自動ナレーション、AI ミュージック

ワン 2.6 完全に オーディオビジュアル AI ビデオモデル単なるサイレントジェネレータではありません。

アリババクラウドのドキュメントによると、wan2.6‑t2vとwan2.6‑i2vはどちらも 自動ナレーションとカスタムオーディオファイルのインポートをサポート生成されたビデオとダイアログ、ナレーション、音楽を同期させることができます。

Akoolでは、WAN 2.6はさらに次の機能を備えています。

- AI ミュージック生成 — テキストプロンプトから、動画と緊密に同期したオリジナルのBGMやフルソングを作成できます。

- マルチボイスオーディオ — ナレーションやキャラクターボイス用にさまざまなボーカルスタイルを生成します。

- ボイス・トゥ・ビデオ — オーディオを使ってリップシンクや顔のパフォーマンスを向上させ、静止画を話したり演技したりするキャラクターに変えます。

このネイティブオーディオサポートにより WAN 2.6 人工知能ビデオ生成 完成したアセットにずっと近い。特にソーシャルメディア、マーケティングビデオ、短い説明動画に便利です。

3。リファレンス駆動型のテキストツービデオおよびイメージツービデオ

WAN 2.6 は以下を中心に構築されています リファレンス駆動制御:

- 画像リファレンス —参照画像をアップロードしてキャラクター、スタイル、または製品の外観を固定できます。一方、WAN 2.6ではその周辺の動きやシーンを生成できます。

- ビデオリファレンスと「何でも主演」 — TongyiのWan 2.6は、リファレンスビデオ内の任意の人物またはオブジェクトが新しいAIビデオの主役になることができるビデオリファレンス生成をサポートしています。

Akoolでは、これは次のように表示されます。

- 参照画像と高度なテキスト・トゥ・ビデオ —プロンプト+リファレンスを組み合わせて、美学、カメラスタイル、被写体のアイデンティティを制御します。

そのため、WAN 2.6は、高速のメリットを享受しながら、ルックアンドフィールを厳密に制御したいクリエイターにとって理想的です。 テキストからビデオへ そして イメージ・トゥ・ビデオ ワークフロー。

4。よりスマートなストーリーテリングとマルチショットコントロール

WAN 2.6 は次の目的で設計されています マルチショットストーリーテリング、シングルクリップだけではありません。

- インテリジェントなマルチシーン・スケジューリング —論理的なトランジションと安定したペースで、アイデアを複数のショットに自動的に分割します。

- インストラクションフォローの改善 —カメラの動き、アクション、感情のトーンなど、複雑なプロンプトをより適切に順守できます。

- 安定運動と物理学 —自然なカメラの動きと一貫した被写体の動き。「AI映画制作」やリアルな短編に適しています。

クリエイターにとっては、複数のビート(セットアップ → アクション → ペイオフ)でシーンを記述できるということです。 Wan 2.6 ストーリー構造が組み込まれた一貫性のある15秒の動画を生成します。

AkoolでWAN 2.6を使用する方法

Akoolが統合されているので ワン 2.6 AIビデオスタジオに直接入力すると、この高度な機能を使用できます AI ビデオモデル シンプルなガイド付きワークフローを通じて。

わかりやすいステップバイステップのプロセスは次のとおりです。

ステップ 1 — Akool で WAN 2.6 を選択する

- にログインします Akool AI ビデオ アカウント。

- ビデオ生成ワークスペースを開いて選択してください ワン 2.6 モデルリストから。(というラベルが付けられているのが分かるでしょう。 オーディオ内蔵の 15 秒マルチシーン AI ビデオジェネレーター。)

ステップ 2 — モードとリファレンスを選択

動画をどのように再生したいかを決めてください。

- テキスト・トゥ・ビデオ AI —シーン、動き、ムードを説明する詳細なプロンプトから始めます。

- 画像から動画へのAI — 参考画像(キャラクター、商品、キービジュアル)をアップロードし、プロンプトを追加します。

- ボイス・トゥ・ビデオ/オーディオ・ドリブン —リップシンクとパフォーマンス用のオーディオトラック(ダイアログまたはVO)を提供するか、WAN 2.6に自動ナレーションと音楽を生成させます。

広告、シネマティックショーツ、ソーシャルフックなどの一般的なシナリオには、Akoolのあらかじめ用意されたテンプレートを使用することもできます。

ステップ3 — 時間、縦横比、スタイルを設定する

- セット 継続時間 (Akoolではクリップあたり最大15秒)。

- 選択 アスペクト比 (横向き 16:9、縦向き 9:16、正方形 1:1)は、チャンネルによって異なります。

- Akool'sを使う シネマティック・ビジュアル・コントロール 照明、カラーグレード、構図をガイドするオプション。

このステップはWAN 2.6の調整を行います AI ビデオ生成 配布計画と一緒に。

ステップ 4 — 生成、レビュー、繰り返し

- クリック 生成 初めての WAN 2.6 クリップを作成します。

- ナラティブフロー、主題の一貫性、音声の同期に注目してください。

- プロンプト、リファレンス、設定を調整し、クリエイティブな意図に合うまで作り直してください。

WAN 2.6は高速で映画のようなレンダリングに最適化されているため、反復ループは短く、実際の制作スケジュールには実用的です。

ステップ 5 — エクスポートと公開

満足のいく結果が得られたら:

- 必要な形式と解像度でビデオをエクスポートします(ほとんどのプラットフォームでは1080pが推奨されます)。

- 有料広告、リール/TikToks/ショートパンツ、予告編、ランディングページ、またはプレゼンテーションで使用してください。

Akoolのエコシステムにより、さまざまなキャンペーンやチャネルの複数のWAN 2.6世代を簡単に管理できます。

結論

ワン 2.6 これは大きな飛躍です AI ビデオ生成:15秒のマルチシーンクリップ、ネイティブオーディオとAIミュージック、リファレンスドリブン テキストからビデオへ そして イメージ・トゥ・ビデオ、よりスマートなナラティブコントロール—すべてを1つのマルチモーダルで AI ビデオモデル。

への深い統合により Akool AI ビデオ、複雑なツールや API をつなぎ合わせる必要はありません。モデルリストから WAN 2.6 を選択し、プロンプトを記述し、参照を追加し、完全に同期された映画のようなクリップを数分で生成できます。これにより、ソーシャルコンテンツ、マーケティングビデオ、予告編などにすぐに使用できます。

ショートフォームビデオをレベルアップさせて、マルチシーンのオーディオ同期AIストーリーテリングの最新機能を試してみたいなら、今が絶好の機会です。

Akoolにログインして、WAN 2.6を今すぐお試しください。